La polémica está servida, una vez más a cuenta de Tesla. Un vídeo publicado en Twitter ha puesto en entredicho la nueva versión del software de conducción autónoma de Tesla.

¿El motivo? Un posible fallo en la última actualización del software de conducción autónoma de Tesla que implica riesgo de atropello para los niños.

Suspenso en una de las pruebas más sencillas

It’s 2022, and Teslas still aren’t stopping for children. pic.twitter.com/GGBh6sAYZS

— Taylor Ogan (@TaylorOgan) August 9, 2022

En las imágenes se muestra un test que pone a prueba la conducción autónoma de un Tesla y un Lexus al mismo tiempo. El reto es sencillo y no debería ser un problema para ninguno de los dos coches: detectar un maniquí del tamaño de un niño y frenar de forma autónoma para no atropellarlo. El Lexus lo consigue y el Tesla se lleva por delante al muñeco.

Los coches utilizados en la prueba son un Tesla Model 3 y un Lexus RX, según parece, ambos de serie. No sabemos quién ha organizado el test ni el motivo por el que se enfrenta a estos dos coches en concreto, pero el Lexus está vinilado con el logo de Luminar.

Eso nos lleva a pensar que esta empresa podría ser la responsable de la prueba. ¿Con qué objetivo? Creemos que sencillamente para demostrar la eficacia de su LiDAR frente a la competencia, en este caso, Tesla.

El muñeco utilizado parece ser el mismo que utiliza el IIHS (Insurance Institute for Highway Safety), también empleado por Euro NCAP. Por lo tanto, es un dummy homologado para este tipo de pruebas. El test ha tenido lugar en Estados Unidos, donde las normas las establece la NHTSA (siglas de Administración Nacional de Seguridad del Tráfico en las Carreteras).

¿Cuál es el fallo del Tesla?

En cualquier caso, suponiendo que la prueba es justa ¿qué habría fallado? No podemos determinar el motivo por el que el Tesla no se detiene ante el muñeco y lo atropella, pero todo apunta a que el problema está en el sistema de conducción autónoma del Tesla.

Por un lado, Tesla utiliza un hardware propio. En lugar del LiDAR (tecnología que mide la distancia del coche a un objeto o superficie a través de láser) de Luminar que equipan casi todos sus rivales, incluido el Lexus del vídeo. Si este sistema no funciona bien, el coche no detecta el muñeco, continúa la marcha y se produce el atropello.

Es tan licito que Tesla utilice un harware propio como que otros fabricantes recurran a Luminar para equipar sus coches. El problema viene cuando el sistema de Tesla no funciona como debería y, al parecer, eso es lo que intenta demostrar el vídeo. Que el hardware de Tesla falle es una explicación plausible al atropello, pero el problema también podría ser el software.

Una campaña que echa más leña al fuego

Y es que el vídeo de Twitter no es el único donde aparece un Tesla atropellando a un muñeco con forma de niño. Hace poco se ha puesto en marcha una campaña para denunciar el mal funcionamiento del software de conducción autónoma de Tesla.

El impulsor de esta campaña, denominada The Dawn Project, es Dan O'Dowd. ¿Quién es este señor? Pues bien, Dan es un ingeniero de software estadounidense que ha trabajado en varias compañías tecnológicas y ahora ha emprendido una cruzada particular contra Tesla.

No sabemos si existe algún interés concreto en la campaña de denuncia del señor O'Dowd más allá de evitar que algún niño acabe atropellado. Lo que está claro es que se está esforzando al máximo por demostrar que los Tesla no son seguros, al menos su sistema de conducción autónoma.

Su teoría señala que el nuevo software de conducción autónoma que incorporan los coches de Elon Musk (Full Self-Driving Beta 10.12.2) es un "serio peligro para la vida humana" porque "falla, de promedio, cada ocho minutos".

Para demostrarlo, Dan ha llevado a cabo un test muy similar al del vídeo de Twitter. La diferencia es que en este caso hay un informe que documenta absolutamente todo. La prueba se llevó a cabo varias veces y, una vez más, el resultado es el atropello del muñeco.

Lo que no queda claro es si el maniquí también está homologado, como el del vídeo de Twitter. Simplemente se informa de su tamaño y de la tienda donde ha sido comprado.

El coche de la prueba es un Tesla Model 3 de 2019 actualizado con la última versión del software de conducción autónoma de Tesla. Según Dan O'Dowd, ese software es el causante de que el Tesla no funcione bien y se lleve al muñeco por delante.

El problema es que no explica cuál es el motivo del fallo. Únicamente dice que el coche actúa de forma confusa cuando se aproxima al muñeco y disminuye ligeramente la velocidad, pero inmediatamente después vuelve a acelerar, haciendo caso omiso de la figura que tiene delante.

Tesla está en apuros en Estados Unidos

Curiosamente, la campaña de Dan llega unas semanas después de que la NHTSA anuncie que está investigando a fondo los accidentes con coches eléctricos con conducción autónoma. Esta investigación podría acabar con una llamada a reivisón masiva de todos los modelos de Tesla en Estados Unidos.

Es más, según Los Angeles Times, el Departamento de Vehículos Motorizados (DMV) de California ha damandado a Tesla por publicitar su sistema de conducción autónoma con más capacidades de las que realmente tiene. Si esta demanda sale adelante, Tesla podría verse obligada a dejar de vender sus coches en California.

Por otro lado, hay que tener en cuenta lo complicado que es garantizar un porcentaje del 100% de seguridad en conducción autónoma. Tiene que existir, por tanto, un margen de error tolerable, como te contamos la razón por la que todavía no tenemos los coches autónomos que nos habían prometido.

Sin embargo, también es cierto que, aunque los sistemas siempre pueden fallar ante imprevistos, las pruebas del vídeo de Twitter y de Dan O'Dowd no pueden considerarse un imprevisto y deberían superarse con relativa facilidad.

Sea como sea, Elon Musk tiene un nuevo frente abierto. Sí, otro más. Mientras tanto, la llegada de Xiaomi y su coche autónomo puede derrocar a Tesla, por lo que la marca de California tiene mucho trabajo por delante.

No solo es cosa de Tesla...

Tampoco hay que olvidar que Tesla siempre sale en las noticias, sobre todo si aparecen vídeos tan espectaculares como el del atropello de un muñeco con forma de niño.

Pero en las pruebas de seguridad no se salva nadie y en Motorpasión no nos olvidamos de algunos de los casos más sonados. No siempre hay vídeos de estas pruebas fallidas, pero cuando los hay y salen a la luz, la polémica siempre está servida.

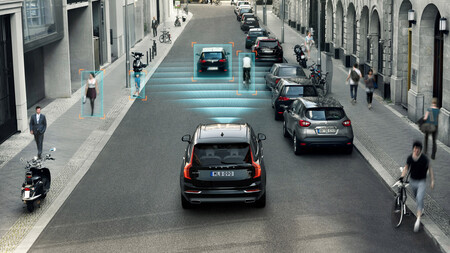

Es el caso de Volvo. En 2015 se hizo viral un vídeo en el que un Volvo XC60 atropellaba a uno de los directivos de la marca en lo que debería ser una demostración del funcionamiento del sistema de detección de peatones con frenada de emergencia. Spoiler: la prueba salió mal. Dentro vídeo.

Unos años antes, en 2010, otro Volvo fue el protagonista de un 'brake test' fallido. En este caso, un Volvo S60 de segunda generación debería detectar un camión parado, pero no lo hizo y acabó estampándose contra la parte trasera del remolque ante decenas de periodistas.

Pero no todos los errores van a ser de Tesla y Volvo. También hay vídeos con fallos en el sistema de frenada de emergencia de Audi, Ford, Hyundai, Kia, Mercedes-Benz, Nissan y Subaru. Estas imágenes demuestran que nadie se libra del margen de error en la conducción autónoma, al menos de momento.

En este último vídeo también aparecen varios modelos atropellando a dummies por culpa de un mal funcionamiento del sistema de frenada de emergencia. Y sí, también hay algún Tesla que otro en las imágenes. Fue publicado por la cadena de televisión CBSDFW para contar que en Estados Unidos muere un peatón por accidente de tráfico cada 88 minutos.

Queda claro, por tanto, que nadie puede fiarse al 100% de los sistemas de conducción autónoma. No es un problema exclusivo de Tesla, pero eso no quita que los vídeos del Model 3 atropellando muñecos con forma de niño sean especialmente llamativos en una prueba que no implica muchas complicaciones, pero que dará mucho que hablar a los miles de defensores y detractores de la marca.

Ver 18 comentarios